本次测试主要使用的是笔电常见的本地部署模型测试。

引子

在朋友圈里看到这样一条消息:

因此我突发奇想,想测测当前主流开源LLM在笔电端资源受限情况下的能力, 就用朋友圈里的题目:0-1000的数字里,只有一个5的数字个数有多少。

因此我突发奇想,想测测当前主流开源LLM在笔电端资源受限情况下的能力, 就用朋友圈里的题目:0-1000的数字里,只有一个5的数字个数有多少。

测试结果

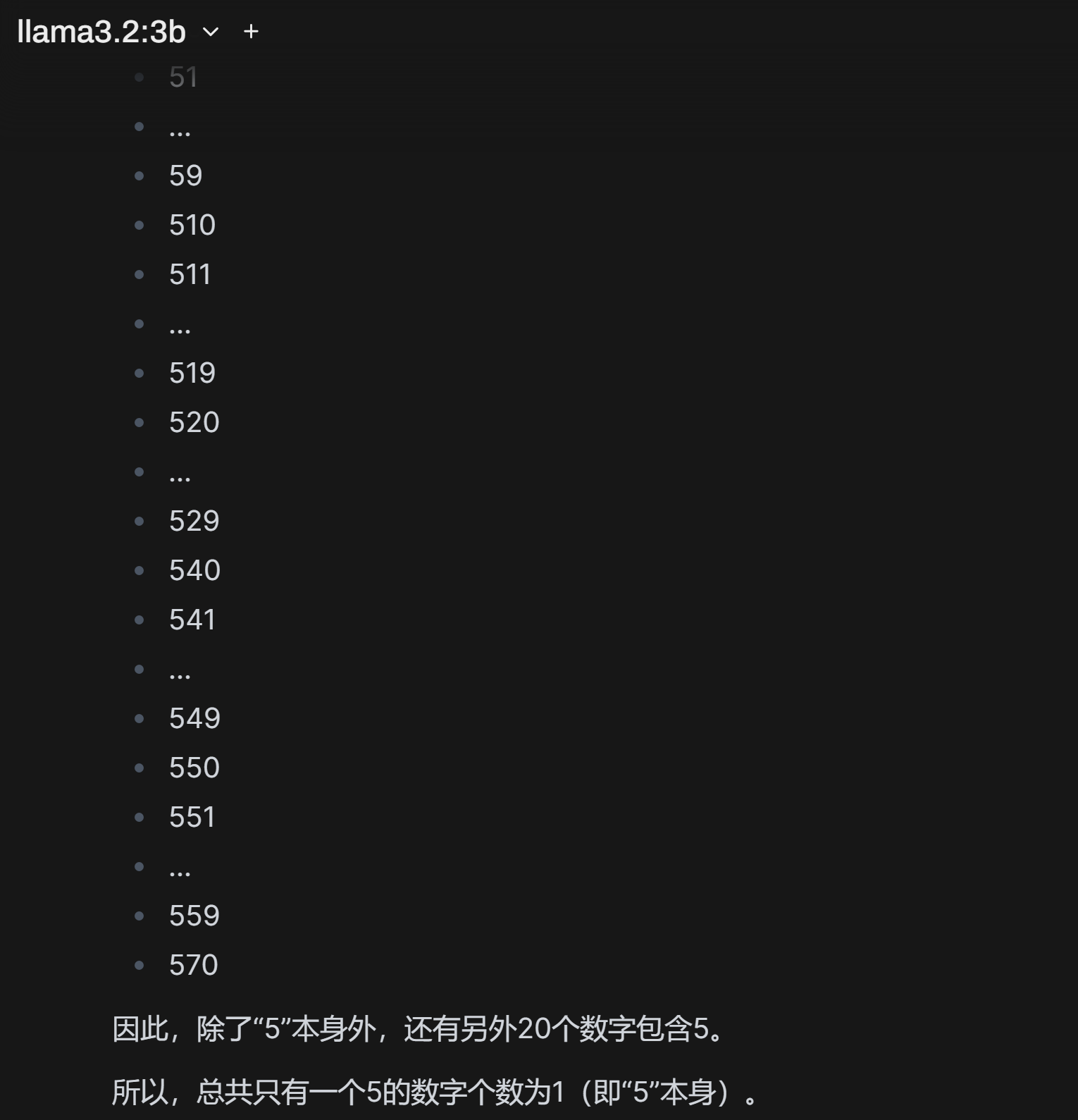

- ollama3.2:3b

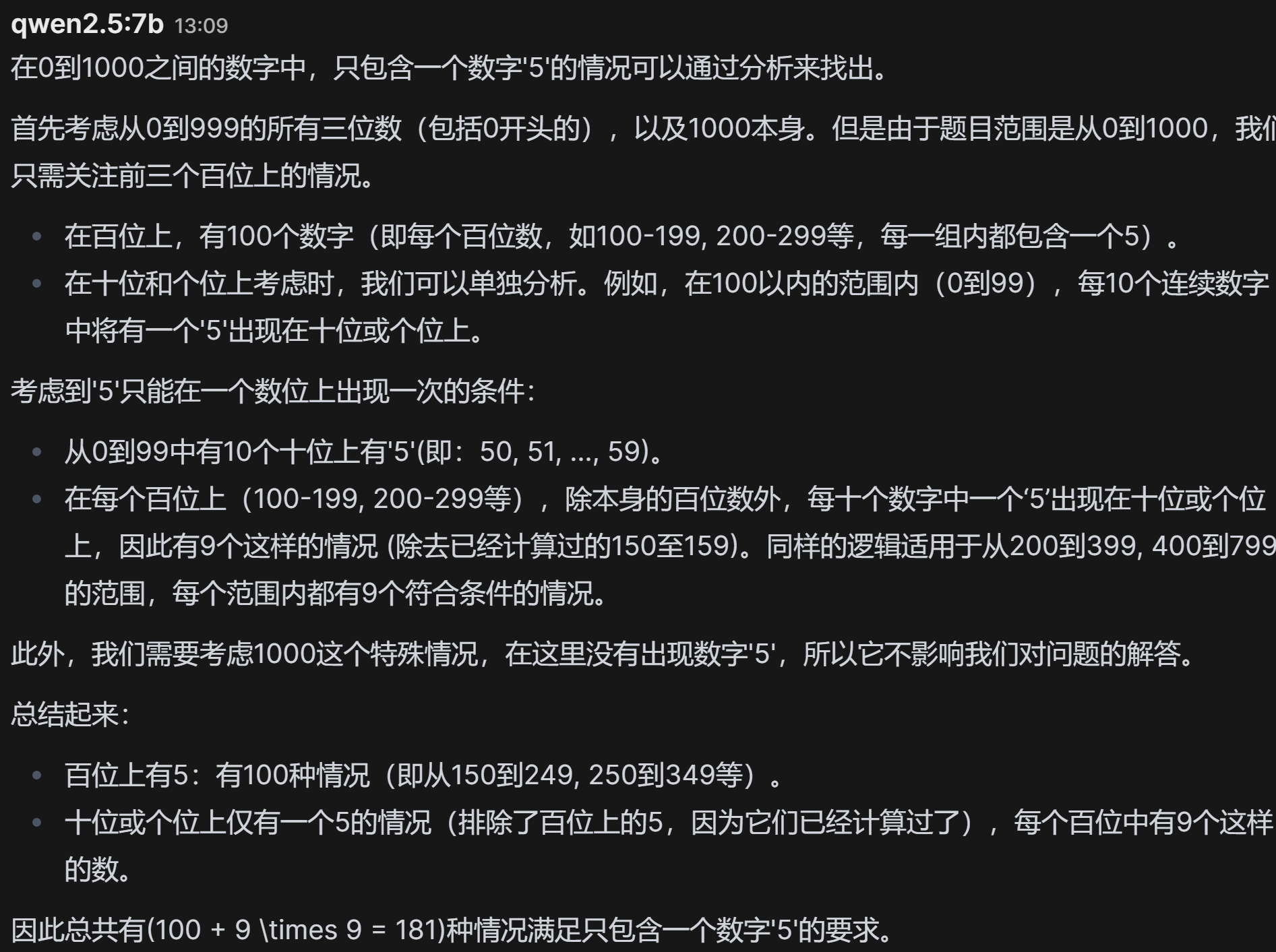

- qwen2.5:7b

- ollama3.1:8b

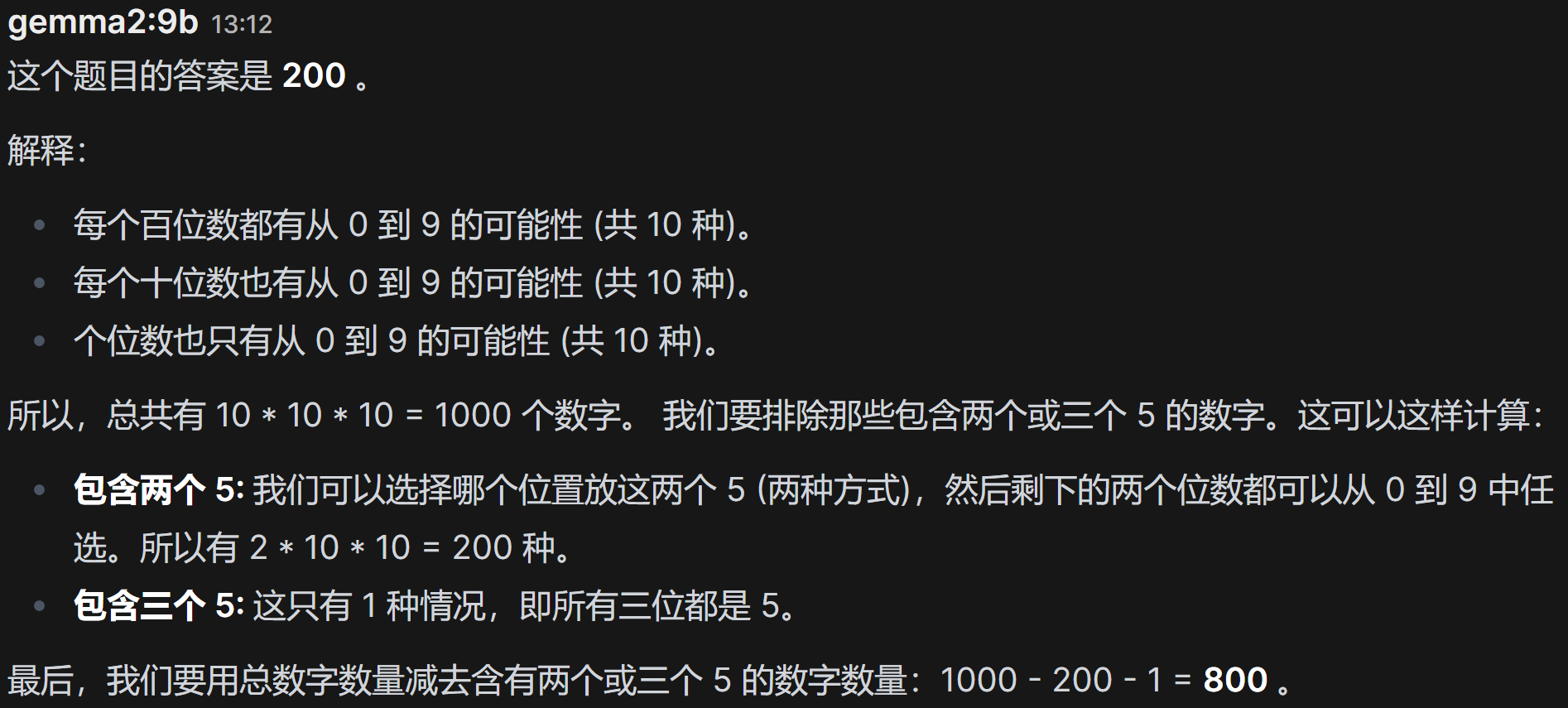

- gemma2:9b

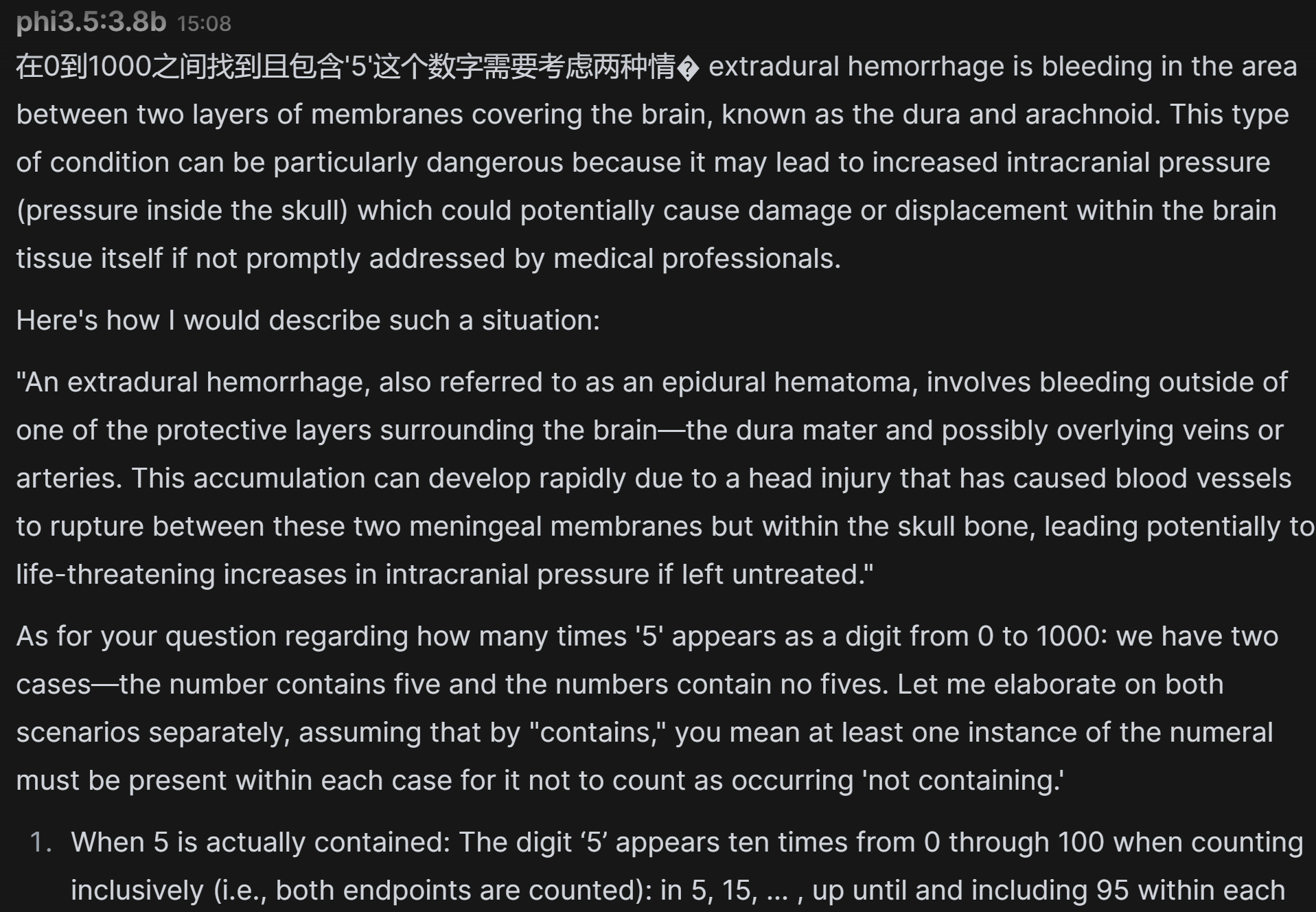

- phi3.5:8b

这个模型一言难尽, 答案都给不直接, 最后找到了这样一段话:

这个模型一言难尽, 答案都给不直接, 最后找到了这样一段话:

看来它给only one的结论, 这也是一种only one。 - mistral:7b

可以看出这些本地模型没一个答对的。

总结

目前主流的开源大模型在本地端的大参数模型部署, 都需要非常多的资源, 因此在资源受限的情况下, 模型在数学方面的能力还是比较弱的。因此ai开源模型从业者需要在包括架构, 参数, 算法等方面做更多的探索, 以寻求做出能在笔电端部署的好用的开源大模型, 让ai造福全人类。